09月22日, 2014 225次

噪声猜测(噪声猜测的无监视进修)

正文实质纲要1、正文从informax(消息最大化)算法动手,证明怎样最大水平地保持输出数据消息,从而进修最优的聚集表征。

2、把表征控制在一个单元范畴内,对于informax算法框架格外利于,正文阐领会个中的口口网因为。

3、一个散布平均的决定性表征能否生存,以及informax算法规范能否到达了最大化,题目的谜底特殊鲜明。因口口网此,即使咱们断定如许的处置本领是真实生存的,那么咱们实足不妨径直探求逼近平均散布的决定性映照。

4、“噪声目的法”(NAT)即是探求一个在单元范畴的边际是平均散布的决定性映照。简直来说即是,从一致样品中,尽管减少本质操纵的“地球挪动隔绝”(EMD)。

5、Bojanowski和Joulin在她们的舆论中提到了随机运用“匈牙利算法”来革新调配矩阵,在正文的结果,我也对此作了大略的阐明。

经过消息最大化举行表征的进修假如咱们此刻将要进修来自于少许 pX散布的数据 xn的一个聚集表征。常常情景下,表征不妨用一个随机变量zn表白,这个变量作过程了少许参数散布前提

的采集样品。

xn∼pX

zn∼pZ|X=xn,

在变革的自源代码器中,这个参数散布前提

会被称为“源代码器”大概是“辨别模子”,又大概是“摊销变革后端”。然而要害的是,咱们此刻是跟“源代码器”举行一对一处事,无需精确地引导出一个天生的散布

。

“消息最大化”规则的道理是一个好的表征的消息熵是聚集散布的,同声还要保持输出X中尽大概多的消息。这一目的不妨正式表白为:

表白“互消息”,

表白“申农熵”。

我还引入了底下的标记散布:

在本质中,那些“最优化题目”有大概是以百般不适合的办法表露的,以是那些题目自己也是生存题目的。

1、普遍情景下,边际的熵是很难测评的。咱们须要采用一种比拟智能的办法来控制

,不须要对熵举行本质的计划。

2、即使一个表征具备决定性和可逆性,那么“互消息”在贯串的空间内即是无穷轮回的,而口口网那些最优化题目就会变得毫偶尔义。以是,为了使那些最优化题目变得有意旨,咱们须要保证那些病态的可逆动作长久都不会展示。

为领会决之上题目,咱们不妨作以次的变换:

1、开始,应用勒贝格有限猜想,把Z的设置域控制在的

子集范畴内,如许一来,微分熵

在这个设置域内就会一直遭到平均散布的熵的牵制。为了与舆论实质普遍,咱们不妨把表征设置域控制在欧几里得单元

的范畴内。

2、第二,试验把

和多噪声表征

(

表白噪声)之间的消息最大化。我将假设

按照了一种球状的散布准则,而这个增添的噪声在本质操纵中,从任何给定的范畴

内,设定了一个

猜测的下限(大概是设定了表征可逆性的下限);进而也框定了“互消息”,把它控制在一个有限值内。那么咱们的最优化题目就形成了:

这个丢失因变量天生了一种直觉的体验:你大概正以一种特殊随机的办法,把你的输出Xn在单元范畴内映照为Zn,然而如许做,原始数据点Xn就会很简单从Zn的噪声版——

回复。换句话来说,咱们是在探求一个在那种水平上不妨抵御加性噪声的表征。

决定和一致的表征咱们能很简单地指出能否生存起码一个表征pZ|X;,这个表征完备以次两种特性:

第一,Zn是Xn的决定性因变量;第二,

是在单元范畴内的平均散布。

即使完备了之上特性,那么这个

即是消息最大化目的中的全部最便宜。

但犯得着关心的是,这个决定性的表征大概并不是举世无双的,大概会生存很多很多好的表征,更加是当

时。

再看如许的案例:假如X是一个规范的多元高斯,表征Z是X的一个平常的正交易投资影。比方,对准少许正交变换A来说:

Z在单元范畴内将会完备平均散布,而这也是一个决定性的映照。所以,Z是一个消息最大化的表征,它对任何同样正交映照A都格外利于。

以是,即使咱们假如只生存起码一个决定的、一致Px的表征,那么探求决定的、不妨把数据映照为大概平均散布的表征就意旨特殊了。

这才是“噪声目的法”(NAT)的手段地方为到达一个在表征空间里平均的散布,NAT沿用的本领是使“地球挪动隔绝”(EMD)最小化。开始,咱们按照已有的数据点,随机画了尽大概多的平均散布,咱们把那些平均散布看作Cn。而后,咱们试着把每个Cn与一个数据点配对,直到Cn和对应的表征

之间的“均方隔绝”到达最小值。一旦配对胜利,已配对的表征和噪声向量之间的“均方隔绝”就能被视为丈量散布平均性的襟怀单元。真实,这是对“瓦瑟斯坦隔绝”(Pz散布和平均散布之间的隔绝)的一种体味性测评。

消息最大化的表征就确定是好的表征吗?往日的几天,我做了太多这种典型的谈话——什么是一个好的表征?无监视的表征进修毕竟是什么道理?对于InfoMax表征,你同样不妨提出如许的题目:这是找到一个好表征的最好引导规则吗?

还不够。对于生人,你不妨以大肆的办法变换你的表征,只有你的变换是可逆的,那么“互消息”就该当是沟通的。以是你不妨在可逆的前提下对你的表征做任何变换,无需商量InfoMax的目的。所以,InfoMax规范不许独立找到你变换过的表征。

更有大概展示的是,咱们在操纵体味中所看到的那些胜利案例都是ConvNets与InfoMax规则共同运用的截止。咱们仅在ConvNet比拟简单展现的表征中,对消息举行最大化操纵。

正文归纳NAT的表征进修规则不妨领会为探求InfoMax表征,即最大化地保持了输出数据的消息的有限熵的表征。在“卷积神经搜集典型”中也生存一致的消息最大化的解读,它按照数据点的噪声版从来测评这个数据点的指数。在发端的功夫,你确定会觉得那些算法很怪僻,以至是超乎常理的,然而即使咱们把那些算法从新领会为消息最大化东西,咱们就会对她们有所变化。归正起码我对她们是有了更深的看法和领会的。

更加实质:少许对于EMD随机本子的小提醒以这种笔墨的办法实行EMD襟怀的难处在乎,你须要找到一个最优的调配计划,调配好两个实际操作体味上的散布和标准

。那么为了侧目这个困难,作家提出了一个“最优调配矩阵”的大肆革新晋级,即一切的配对一次只举行第一小学批革新晋级。

我并不巴望这个“最优调配矩阵”能有多有效,然而犯得着一提的是,这一矩阵使这个算法很简单堕入限制的最小值。假如表征

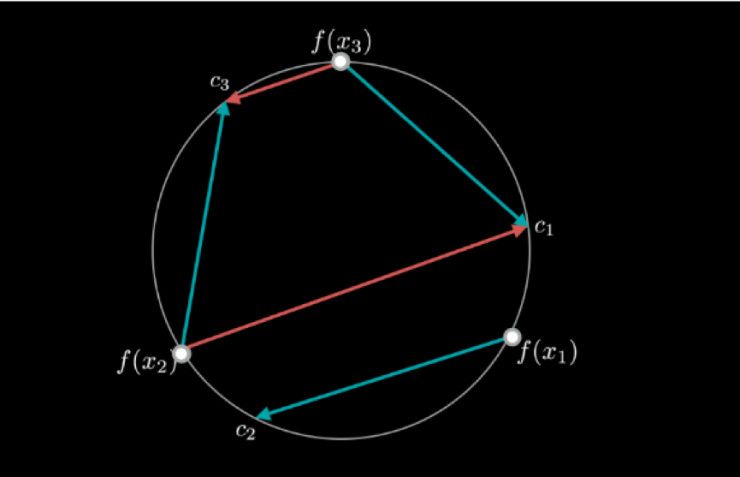

的参数是恒定的,咱们变革、革新的不过个中的调配。咱们来看底下图形中的解读:

在这个2D的球状单元(圈子)上的X1,X2,X3辨别是三个数据点,那些数据点之间隔绝十分。是三个大概的噪声调配,三者之间也是隔绝十分。C1,C2,C3很鲜明,个中的最优调配即是把X1与C1配对,X2与C2配对,X3与C3配对。

假如,咱们暂时的映照是次优的,如图中蓝色箭镞引导的;并且咱们此刻只能在尺寸2的minibatch上革新调配。在尺寸2的minibatch上,咱们的调配惟有两种大概性:第一,维持从来的调配静止;第二,把一切的点都调换,就像图中赤色箭镞引导的。在上海图书馆这个例子中,维持从来的调配(蓝色箭镞)比调换一切的点(赤色箭镞)更可行。所以,minibatch的革新将会使minibatch算法堕入这个限制的最小值。

然而这并不表示着这个本领没有效。当

也同声被革新了的情景下,这个本领真实能让算法解脱这个限制最小值。其次,batch的尺寸越大,就约难找到如许的限制最小值,那么算法也就越不会堕入最小值。

咱们不妨变换一种思想办法,把这个大肆的“匈牙利算法”的限制最小值看作是一个图表。每一个节点代办一个调配矩阵状况(一个调配陈设),每一条边对应一个鉴于minibatch的灵验革新。一个限制最小值即是一个节点,这个最小值节点与其周边的N!节点比拟本钱较低。

即使咱们把本来巨细为B的minibatch夸大到一个总样品的尺寸N,那么咱们就会在图中获得一个N!节点,而每个节点城市胜过额度,到达

。那么大肆两个节点贯穿的几率即是

。Batch的B尺寸越大,咱们这个图表就会变得越精细,限制最小值也就不生存了。